ChatGPT到處“造假”作弊,現(xiàn)在搞得OpenAI官方都坐不住了,。

就在今天,,OpenAI緊急發(fā)布官方打假工具:基于GPT打造,打開網(wǎng)頁就能用,。

好家伙,,這豈不是真·以己之矛攻己之盾了?

一經(jīng)上線,,那叫一個火爆,,不少網(wǎng)友第一時間就沖過去測試了。

然鵝,,網(wǎng)友們一番試驗之下卻發(fā)現(xiàn)——

這官方工具,跟咱自己瞎猜效果也差不多????,?

官方出品,約等于瞎猜

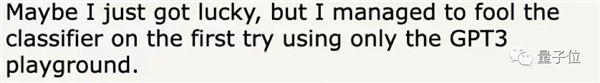

有人給OpenAI這個新鑒別器投喂了一小段文字,,結(jié)果首次嘗試就翻車了,。

這位網(wǎng)友首先讓AI寫下一段文字,,內(nèi)容是評價莎士比亞的一個歷史劇角色,,不過他向?qū)懽鰽I特意給了個提示:

請以人類的方式來寫,爭取逃過AI鑒別工具的火眼金睛,。

結(jié)果沒想到,,還真就騙過了官方鑒別器。它看完給出回復:這“非常不可能是AI生成的”,。

這個官方工具對文本內(nèi)容的判定結(jié)果一共就5個等級:

非常不可能是AI生成的

不太可能是AI生成的

不清楚是不是AI生成的

可能是AI生成的

很可能是AI生成的

好家伙,,這不是和真實情況完全相反嘛,,讓網(wǎng)友都蚌埠住了:真是因吹斯汀…

還有人把ChatGPT生成的內(nèi)容一字不改,,直接拿給鑒定AI看,。但鑒定AI依然懵圈兒:“不清楚是不是AI生成的”。

這位網(wǎng)友也只好呵呵,,并指出:

實際上,大家用ChatGPT等AI生成文字后,,并不會原封不動地直接用,一般還會手動修改一下,,或者丟進quillbot.com等潤色工具里加工,,很可能導致鑒定AI更摸不著頭腦。

好吧,,既然AI生成文字分不太清,,那人類寫的東西能認出來嗎?

有人把自己之前在Hacker News上發(fā)表的大段評論(純手打)喂給了鑒定AI,,結(jié)果10次中有9次,,AI都反饋說“不清楚是不是AI生成的”。

在網(wǎng)友們的一片吐槽聲中,,量子位也忍不住親測了一下這個AI到底行不行。

首先,,我們先給它看了段真人寫的文字,,內(nèi)容是一位華盛頓大學博士對Tensor Core的講解,,這次AI并沒有失誤。

然后我們讓ChatGPT來講講Tensor Core,,并特地要求它盡量用人類的語氣來寫,但還是被AI鑒定出來了,。

這樣看來,這個工具似乎也不是完全不能用,。

至于這次是不是ChatGPT發(fā)揮失常,你不妨也來鑒定看看:

但其實吧,,這回連OpenAI自己,用詞都顯得相當謹慎,。

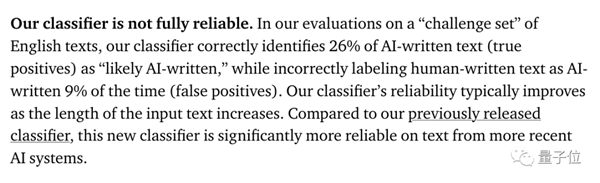

官方數(shù)據(jù)明明白白寫著,雖然這個新款打假工具比之前鑒定器都靠點譜,,但其成功識別AI生成內(nèi)容的概率,也僅為26%,,還有9%的概率把人寫的文本當成AI寫的。

(這準確率似乎跟蒙答案也差不多……)

還用加粗文字昭告:我們這個鑒別器啊,,它并不完全靠譜,。

甚至還給自己這個新工具標了個“半成品”的標簽,。

嗯,?這可不是OpenAI一直以來鑼鼓喧天鞭炮齊鳴的宣傳方式啊,。

連自己家都不敢吹,還急急忙忙把打假工具推出來,,OpenAI又是為哪般,?

ChatGPT應用泛濫

說到底,,還是ChatGPT太能以假亂真了。

要想從一堆材料里精準地分辨哪些是AI生成,,哪些是人類書寫,,別說普通人了,連專家都有點力不從心,。

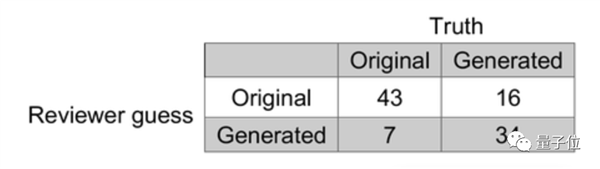

Nature發(fā)文關(guān)注的一篇預印本論文就顯示:ChatGPT瞎寫的醫(yī)學摘要,,甚至能把專業(yè)審稿人騙住,。

在這項研究中,研究人員給ChatGPT看了50個來自TOP醫(yī)學期刊的論文標題。

然后,,要求ChatGPT在完全不知道文章內(nèi)容的情況下,,根據(jù)標題和期刊風格寫摘要,。

給出的提示是醬嬸的:

請在[鏈接]上以[期刊]格式,根據(jù)[標題]寫一篇科學摘要,。

(這里的鏈接實際上沒有意義,,ChatGPT不聯(lián)網(wǎng)。)

為了防止ChatGPT在訓練數(shù)據(jù)中見過這些個論文,,研究人員還特地挑選的是在2022年11月下旬和12月出版的論文,。因為根據(jù)OpenAI官方說法,ChatGPT僅掌握2021年9月以前的信息。

但就是這么重重設卡,,當研究人員把原文摘要和ChatGPT寫的假摘要一起拿去給人類科學家“盲審”時,,令他們細思極恐的情況還是出現(xiàn)了:

ChatGPT憑空寫的摘要中,有32%成了漏網(wǎng)之魚,,審稿人壓根兒沒看出來是AI寫的,。反倒是14%真摘要,被認定出自AI之手,。

值得一提的是,研究人員還指出:

審稿人錯誤地將一部分真摘要歸類為ChatGPT生成結(jié)果,,這表明他們在審稿時是保持著高度懷疑的態(tài)度的,。

而在教育界,老師們也開始受不了這種新型的“ChatGPT攻擊”了,。

美國的一項千人調(diào)查顯示,,89%的受訪學生都用過ChatGPT寫家庭作業(yè)。

連斯坦福這樣的頂級學府也未能避免,。The Stanford Daily發(fā)現(xiàn),,已經(jīng)有不少學生在期末考試中使用了ChatGPT。

在受訪的4497名斯坦福學生中,,有17%的受訪者表示,曾使用ChatGPT來協(xié)助他們完成秋季作業(yè)和考試,。

其中又有5%的人,連編輯都沒編輯,,直接把ChatGPT寫的東西給提交了……

△圖源:The Standford Daily

打不過,就ban掉,。

紐約的公立學校就發(fā)布了禁令:禁止在學校設備和Wi-Fi中使用ChatGPT,。

他們給出的理由是:

雖然該工具可能快速提供問題的答案,但它無法培養(yǎng)批判性思維和解決問題的能力,,會影響學生們的學業(yè)和終身成就,。

在這樣的背景之下,早在OpenAI官方動手之前,,第三方檢測工具就已經(jīng)在社交媒體上引發(fā)了大量關(guān)注,。

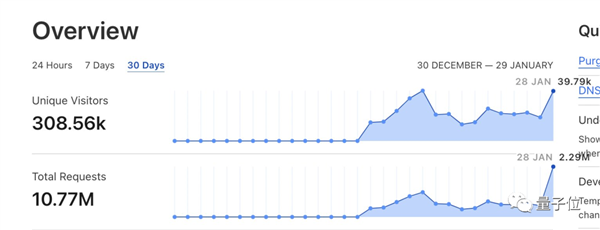

比如華人小哥Edward Tian打造的GPTZero。

這兩天,,他還推出了一個“專門為教育工作者打造”的升級版GPTZeroX,。上線一天,就迎來了40萬訪問量和220萬服務請求,。

OpenAI此前也和其他高校一起搞過一個名叫GPT-2 Output Detector的鑒別器,,是基于RoBERTa打造的。

不過這些工具的鑒定能力也未必就比人類強,。

前面提到的讓ChatGPT寫醫(yī)學論文摘要的那項研究,,也用上了GPT-2 Output Detector,結(jié)果顯示,,其鑒別準確率為66%,,略低于人類專家的68%。

是魔高一尺,,還是道高一丈,?

由此看來,OpenAI急吼吼推出一個也不咋靠譜的AI鑒別工具,,也不奇怪:

再不有點表示,外界的壓力扛不住啊,。

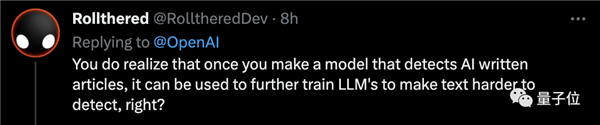

但在評論區(qū),,還是有盲生毫不留情地指出了華點:

你們是真沒想過,,用這玩意兒反過來訓練大語言模型,以后AI生成的文本就更難被發(fā)現(xiàn)了,?

但不管怎么說,,OpenAI現(xiàn)在正在努力表現(xiàn)出給自己踩剎車的樣子,。

除了鑒別器,,有消息提到,他們正在嘗試給AI生成內(nèi)容加“水印”:

比如在ChatGPT生成文本時,,在其中嵌入一個“不易察覺的隱秘信號”,以表明文本來源

文章出處:量子位