ChatGPT一夜間再次進化,,OpenAI一口氣推出大量更新,!

最核心的是API新增函數(shù)調(diào)用(Function calling)能力,,與網(wǎng)頁版的插件類似,API也能使用外部工具了,。

這個能力被交到開發(fā)者手上,,ChatGPT API原本不具備的能力也都能靠各種第三方服務(wù)解決了。

有人認為,,這是一個殺手級特性,,也是自ChatGPT API發(fā)布以來最重要的更新。

另外這次關(guān)于ChatGPT API的更新每一個都很重磅,,不僅能力加量,價格還更低了:

推出新版本gpt-4-0613和gpt-3.5-turbo-0613模型

gpt-3.5-turbo上下文長度增漲400%,,從4k增長到16k

gpt-3.5-turbo輸入token降價25%

最先進embeddings model降價75%

GPT-4 API大規(guī)模開放,,直到清空排隊列表為止

消息到了國內(nèi),也有網(wǎng)友認為這是國內(nèi)大模型面臨的重大挑戰(zhàn),。

何時使用工具,,API自己決定

根據(jù)OpenAI官方介紹,函數(shù)調(diào)用同時支持新版GPT-4和GPT-3.5,。

開發(fā)者只需要模型描述需要用到的函數(shù),,何時調(diào)用哪個函數(shù)都是模型根據(jù)提示詞自己決定的,與ChatGPT調(diào)用插件的機制一樣,。

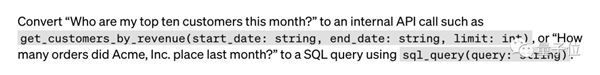

對于具體使用方法,,官方給出了三個例子:

第一,聊天機器人調(diào)用外部API執(zhí)行操作或回答問題,,如“給某人發(fā)郵件”或“今天的天氣如何?”,。

第二,,將自然語言轉(zhuǎn)換為API調(diào)用或數(shù)據(jù)庫查詢,,如“上個月有多少訂單?”會自動生成SQL查詢語句,。

第三,,從文本中自動提取結(jié)構(gòu)化數(shù)據(jù),,如只需要定義好需要的“人名、生日,、位置”,,再給個網(wǎng)頁鏈接,就可以自動提取一篇維基百科文章中提到的所有人物信息,。

這一新功能讓廣大網(wǎng)友,、特別是開發(fā)者為之歡呼,,表示有了它工作效率將大大提高。

以前,想要讓GPT調(diào)用函數(shù)需要借助LangChain的工具才能實現(xiàn),。……盡管LangChain理論上擁有更高的運行效率,,但可靠性要遜于經(jīng)過專門調(diào)教的新GPT。

更新版本,更低價格

目前,,新版本的模型已經(jīng)逐步開始迭代,。

最新版gpt-4-0613、gpt-3.5-turbo-0613與擴充上下文長度的gpt-4-32k-0613都支持函數(shù)調(diào)用,。

gpt-3.5-turbo-16k不支持函數(shù)調(diào)用,,提供4倍上下文長度,意味著一次請求可支持約20頁文本,。

舊模型也開始逐步廢棄,。

使用初始版本gpt-3.5-turbo、gpt-4的應(yīng)用將于6月27日自動升級到新版本

需要更多時間過渡的開發(fā)者也可以手動指定繼續(xù)使用舊版本,,但9月13日之后所有舊版本請求將徹底廢棄,。

說完這個時間線,我們再來看看價格,。

升級之后,,OpenAI不僅沒有讓產(chǎn)品漲價,反而下調(diào)了價格,。

首先是使用量最大的的gpt-3.5-turbo(4k token版),。

輸入token的價格降低了25%,現(xiàn)在0.0015美元每千token,,也就是1美元66.6萬token,。

而輸出token每千token的價格則為0.002美元,也就是1美元50萬token,。

換算成英語文本的話,,大致是1美元700頁。

嵌入模型(embeddings model)的價格更是大跳水,,直接降低了75%,。

每千token只需0.0001美金,也就是1美元一千萬token,。

此外,,新推出的16K token版GPT3.5-Turbo提供了4K版本四倍的處理能力,但價格只有兩倍,。

輸入及輸出token的價格分別是0.003和0.004美元每千token,。

另外還有少數(shù)網(wǎng)友反應(yīng),,當月賬單直接從100到降到幾美分了,目前還不清楚具體什么情況,。

最后,,有需要的話也不要忘記去排隊GPT-4 API的測試資格,。

(傳送門放在文末)

OpenAI捕“Chain”,微軟在后

不少網(wǎng)友指出,,OpenAI新出的“函數(shù)調(diào)用”基本就是Langchain里“Tools”的翻版,。

也許接下來,OpenAI還會翻版Langchain的更多功能,,如Chains和Indexes,。

Langchain是大模型領(lǐng)域最火的開源開發(fā)框架,,能夠把各種大模型能力整合起來快速構(gòu)建應(yīng)用程序。

團隊最近也剛剛獲得1000萬美元種子輪融資,。

雖然OpenAI的這次更新還不至于直接“殺死”Langchain這個創(chuàng)業(yè)項目,。

但是開發(fā)者們本來需要LangChain才能實現(xiàn)一些功能,現(xiàn)在確實不再需要了,。

再看Langchain一方的反應(yīng),,求生欲也確實很強。

在OpenAI官推發(fā)布更新的10分鐘之內(nèi),,Langchain立馬宣布“已經(jīng)在做兼容工作了”,。

并且不到一個小時就發(fā)布了新版本,支持官方新功能之外,,還可以把開發(fā)者已經(jīng)寫好的tools轉(zhuǎn)換成OpenAI的functions,。

一眾網(wǎng)友除了排隊感嘆這快得離譜的開發(fā)速度,,還思考起一個無法回避的問題:

OpenAI把你的創(chuàng)業(yè)項目給做了怎么辦?

對此,,OpenAI首席執(zhí)行官Sam Altman最近剛好做過一次表態(tài),。

在5月底Humanloop舉辦的交流會上,Altman曾表示:

除了ChatGPT類型的消費級應(yīng)用之外,,盡量避免與客戶競爭,。

現(xiàn)在看來,,開發(fā)工具似乎不算在避免競爭的范圍之內(nèi)。

而與OpenAI形成競爭關(guān)系的除了創(chuàng)業(yè)公司,,還有一個不可忽視的存在:

微軟,,OpenAI最大金主,通過Azure云也對外提供OpenAI API服務(wù),。

就在最近,,有開發(fā)者反饋,從OpenAI官方API切換到微軟Azure版本后,,性能顯著提升,。

具體來說:

median latency從15秒減少到3秒

95th percentile latency從60秒減少到15秒

平均每秒處理的token數(shù)量增加了三倍,,從8個增加到24個。

再算上Azure給的一些折扣,,甚至比原來還便宜了,。

但微軟Azure的更新速度一般要比OpenAI慢上幾周。

開發(fā)階段快速迭代用OpenAI,,大規(guī)模部署轉(zhuǎn)去微軟Azure,,你學(xué)到了么?

更新公告:https://openai.com/blog/function-calling-and-other-api-updates

GPT-4 API排隊:https://openai.com/waitlist/gpt-4-api

參考鏈接:

[1]https://news.ycombinator.com/item?id=36313348

[2]https://twitter.com/svpino/status/1668695130570903552

[3]https://weibo.com/1727858283/N5cjr0jBq

[4]https://twitter.com/LangChainAI/status/1668671302624747520

[5]https://twitter.com/hwchase17/status/1668682373767020545

[6]https://twitter.com/ItakGol/status/1668336193270865921

文章出處:量子位